1. 神经网络中的神经元本质上是输入、隐藏或输出神经元。输入和输出神经元将信息传入和传出神经网络。隐藏神经元出现在输入和输出神经元之间,用于处理信息。神经网络可以构建逻辑表达式,使用AND、OR和NOT便可构建更复杂的逻辑表达式。

2. 经典的神经网络结构包括自组织映射、霍普菲尔德神经网络和玻尔兹曼机等。

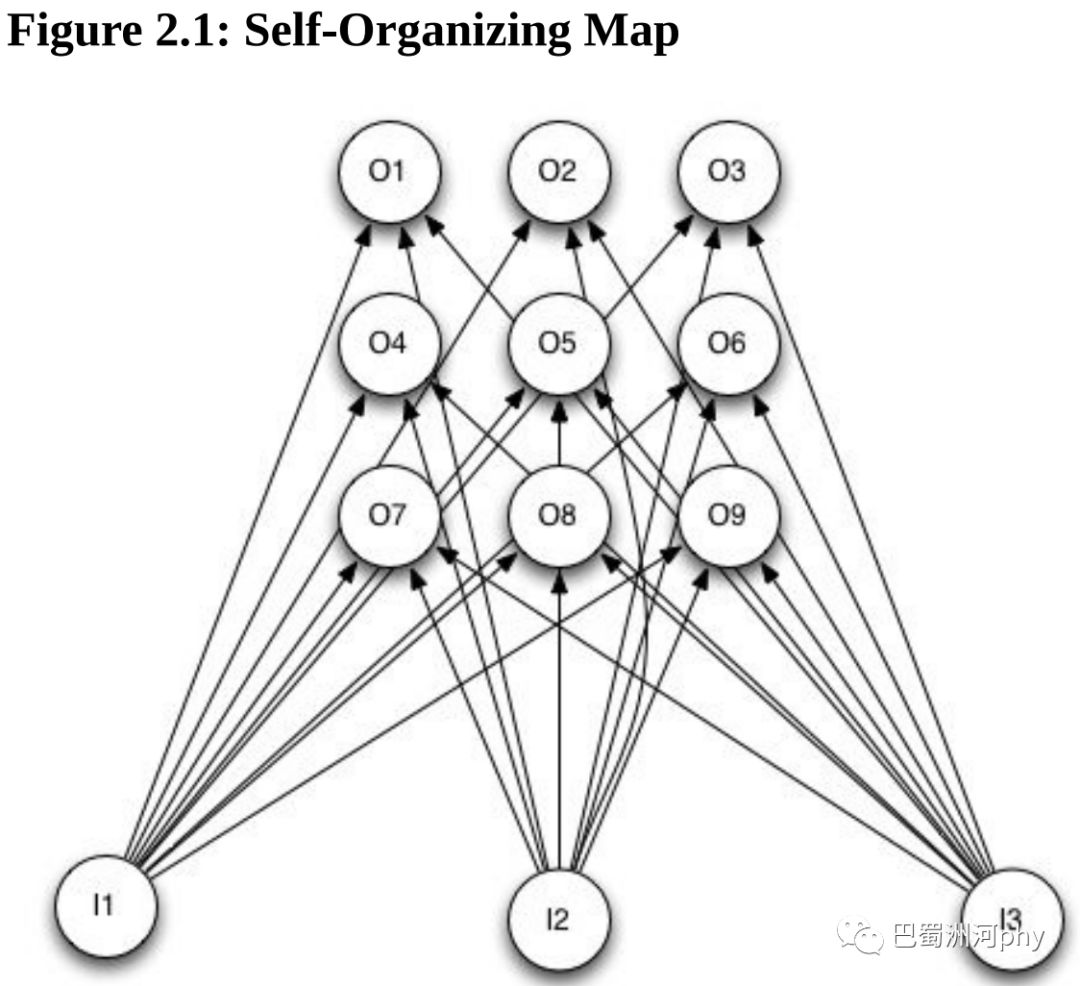

3. Kohonen于1988年引入了自组织映射,这是一个由输入层和输出层组成的神经网络。两层SOM也被称为Kohonen神经网络。当程序将模式提供给输入层时,如果输出神经元包含与输入最相似的权重,它就被认为是赢家。值得注意的是,大多数神经网络中,一个输出神经元与另一个输出神经元的接近程度并不重要。但对于SOM,一个输出神经元与另一个输出神经元的接近程度很重要。计算机视觉应用程序利用神经元的接近程度来更准确地识别图像。

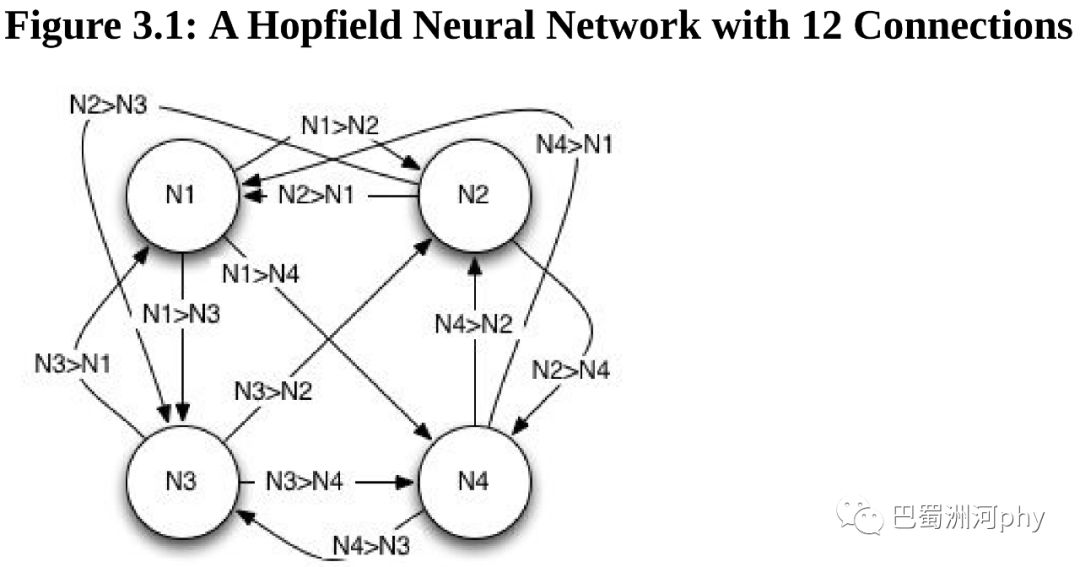

4. 霍普菲尔德神经网络是一种简单的神经网络,可以识别模式和解决优化问题。

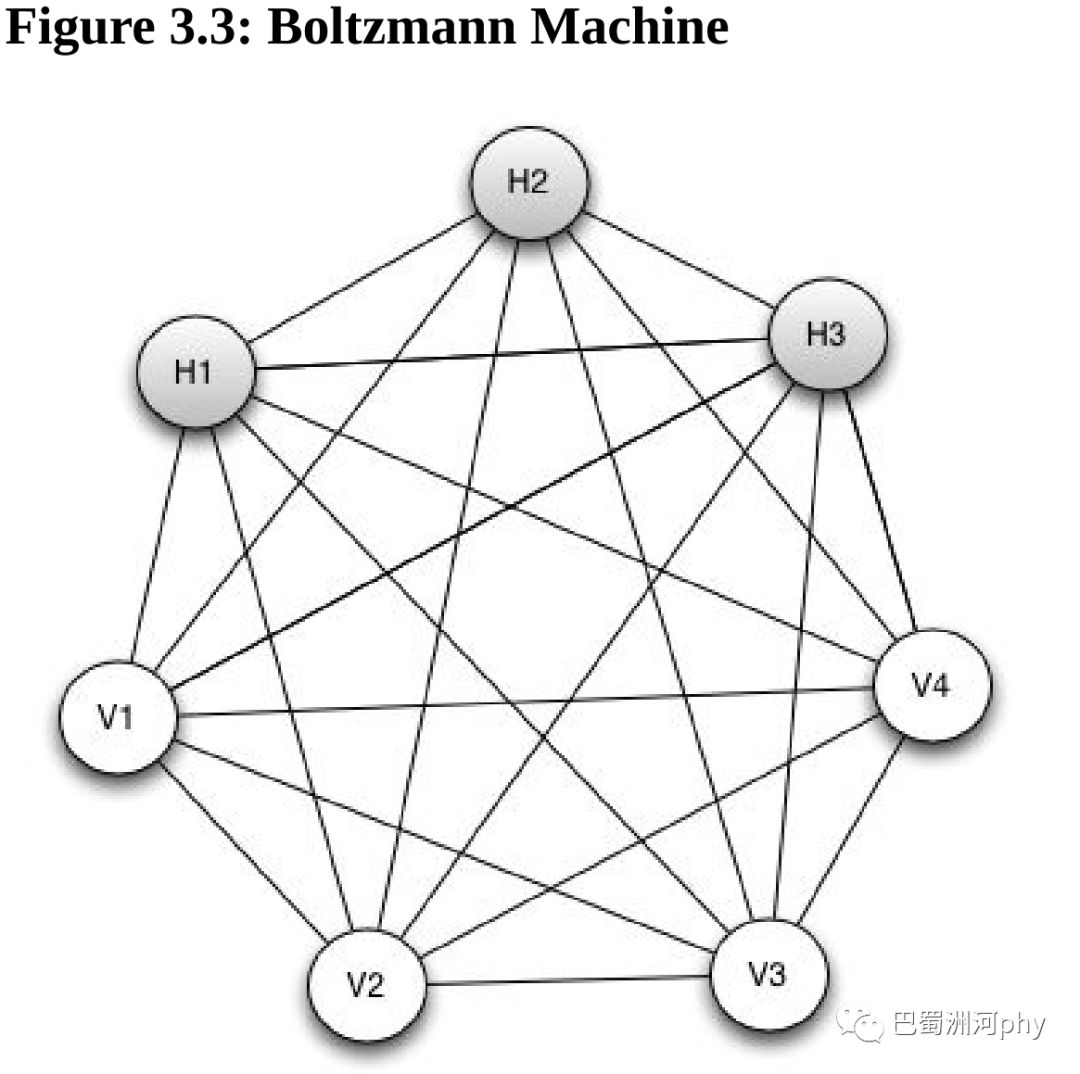

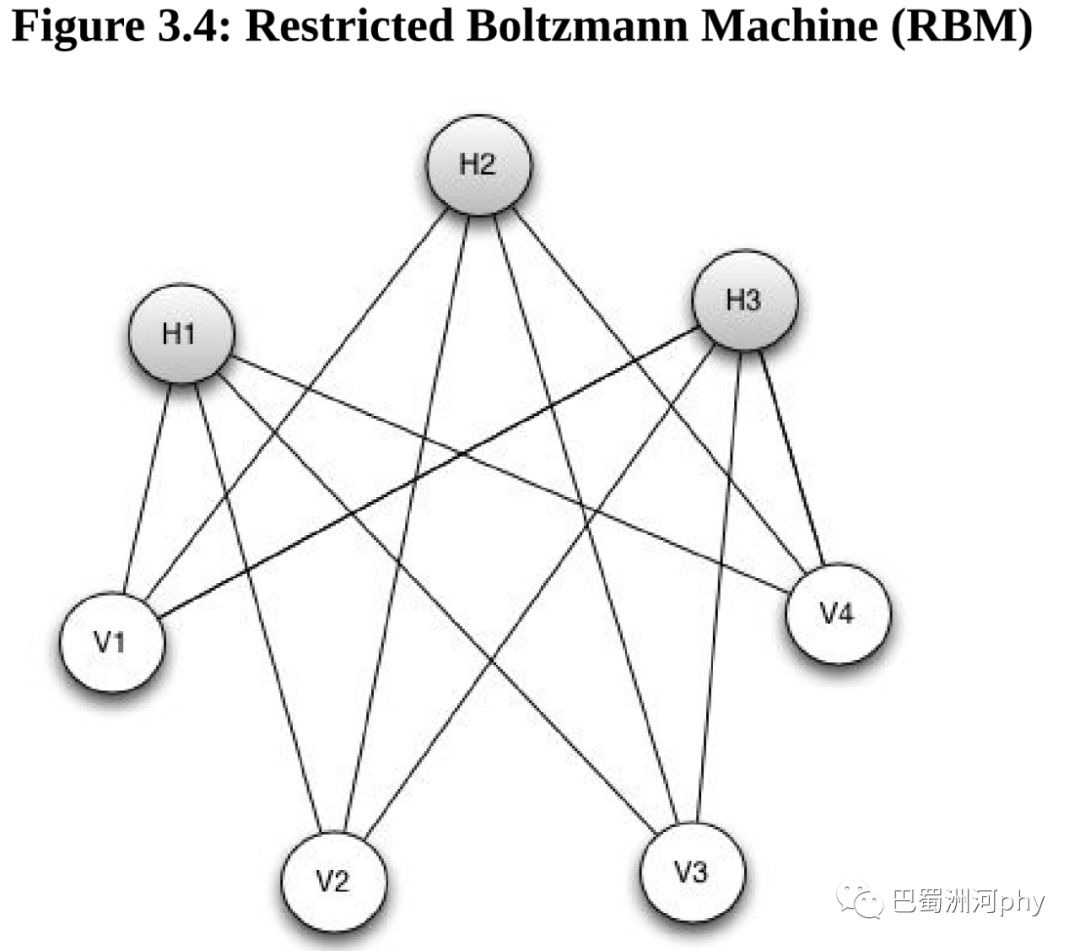

5. 玻尔兹曼机本质上是一个完全连接的两层神经网络。我们将这些层称为可视层和隐藏层。可视层类似于前馈神经网络中的输入层。事实上,尽管玻尔兹曼机具有隐藏层,但它更多地充当了输出层。隐藏层含义的这种差异,通常是玻尔兹曼机与前馈神经网络之间产生混淆的根源。

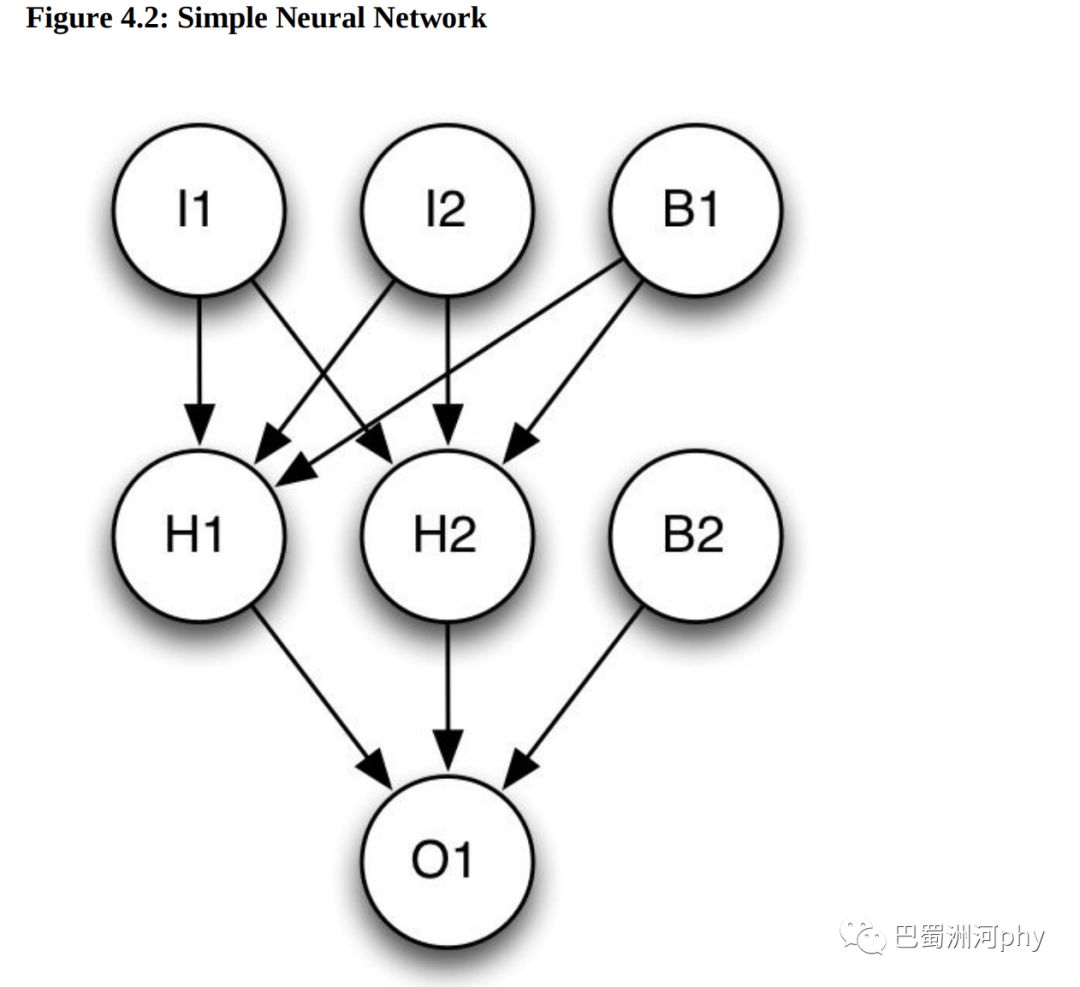

6. 最常见的神经网络架构:前馈神经网络。其用途广泛,非常受欢迎。前馈神经网络具有定义明确的层。输入层接受来自计算机程序的输入。输出层将神经网络的处理结果返回给调用程序。在输入层和输出层之间是隐藏的神经元,它们帮助神经网络识别在输入层提供的模式,并在输出层产生正确的结果。

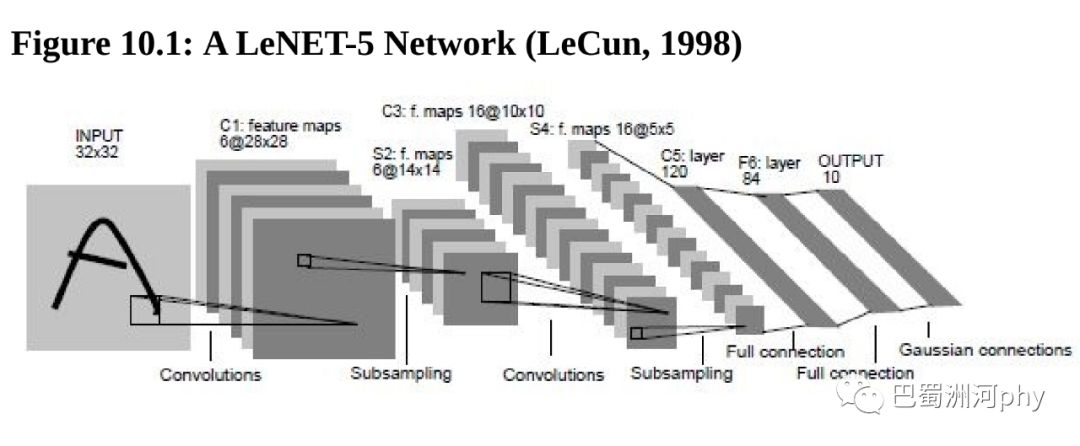

7. CNN,即卷积神经网络,是一种神经网络技术,它已深刻地影响了计算机视觉领域。

最常见的卷积神经网络是LeNet-5。这种神经网络由稠密层、卷积层和最大池层组成。稠密层的工作方式与传统前馈神经网络完全相同,最大池层可以对图像进行缩小采样并去除

细节,卷积层检测图像视野中任何部分的特征。

8. 前馈神经网络和LeNet-5神经网络之间存在几个重要区别:前馈神经网络传递向量,LeNet-5神经网络传递3D立方体数据集;LeNet-5神经网络包含多种层类型;计算机视觉是LeNet-5的主要应用。

最重要的相似之处在于,可以使用相同的基于反向传播的技术来训练LeNet-5。绝大多数优化算法都可以训练前馈或LeNet-5神经网络的权重。

8-1. 卷积层的主要目的是检测特征,如边缘、线条、颜色斑点和其他视觉元素。卷积层与它的上一层之间具有权重。每个卷积层上的每个像素都是一个权重。

8-2. 最大池层将3D盒子缩小采样为更小的新盒子。通常,总是可以在卷积层之后立即放置一个最大池层。

8-3. LeNet-5神经网络中的最后一个层是稠密层。该层类型与我们在前馈神经网络中看到的层类型完全相同。稠密层将上一层输出的3D盒子中的每个神经元连接到稠密层中的每个神经元,对生成的向量使用激活函数。LeNet-5神经网络通常使用ReLU激活函数。我们也可以用S型激活函数,尽管这种技术不太常见。

9. 前馈神经网络始终具有前向连接。循环神经网络允许反向连接。循环连接将一层中的神经元连接到上一层或神经元本身。大多数循环神经网络架构都在循环连接中保持状态。前馈神经网络不保持任何状态。循环神经网络的状态充当了神经网络的一种短期记忆,因此,循环神经网络对于给定的输入将不会总是产生相同的输出。

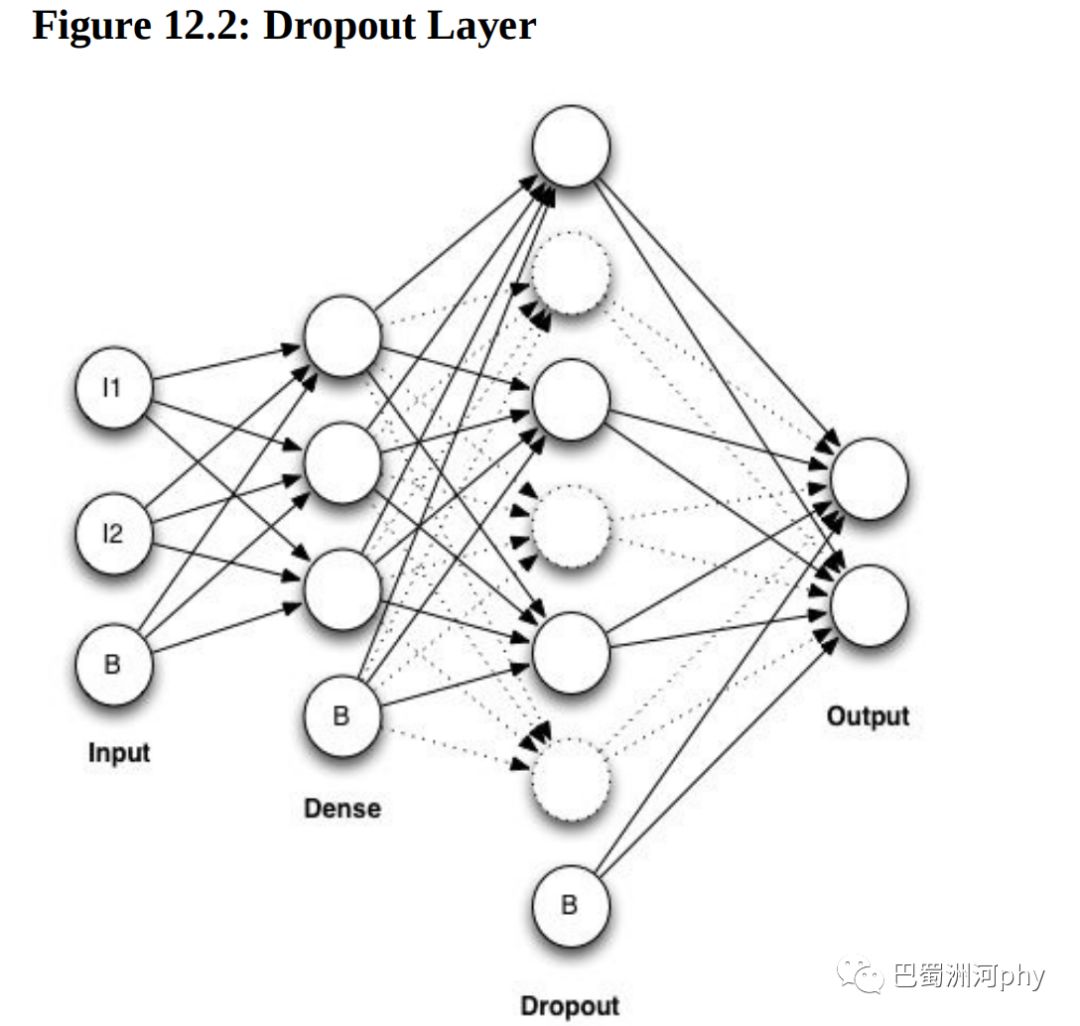

10. 正则化是一种减少过拟合的技术。L1和L2正则化是两种常见的正则化技术(或称算法)。Dropout正则化算法的工作方式不同于L1和L2,它也减少过拟合。该算法实际上是通过(至少暂时)去除神经元和连接来完成任务的。与L1和L2不同,Dropout不增加权重罚分,且不直接寻求训练更小的权重。Dropout的工作方式,是在部分训练期间,让神经网络的一些隐藏神经元不可用。这减少了神经元之间的连接,从而减少了过拟合。

好了,分享到这里就结束啦!如果发现错误,我也会及时更正。

参考文献:

【1】杰弗瑞·希顿.人工智能算法(卷1):基础算法.北京,人民邮电出版社出版.

【2】杰弗瑞·希顿.人工智能算法(卷2):受大自然启发的算法.北京,人民邮电出版社出版.

【3】杰弗瑞·希顿.人工智能算法(卷3):深度学习和神经网络.北京,人民邮电出版社出版.

以上内容来源于网络,由“WiFi之家网”整理收藏!

原创文章,作者:电脑教程,如若转载,请注明出处:https://www.224m.com/222554.html